1erjuin 2021 — Le Conseil de sécurité de l’ONU a officiellement confirmé que des drones avaient exécuté des personnes sans avoir reçu d’ordre !

Ce n’est plus de la science-fiction, c’est devenu une réalité pour la première fois dans l’histoire de l’humanité, la mort d’une personne tuée par un robot de combat fonctionnant de manière totalement autonome et prenant la décision de l’éliminer sans avoir reçu aucun ordre d’un humain.

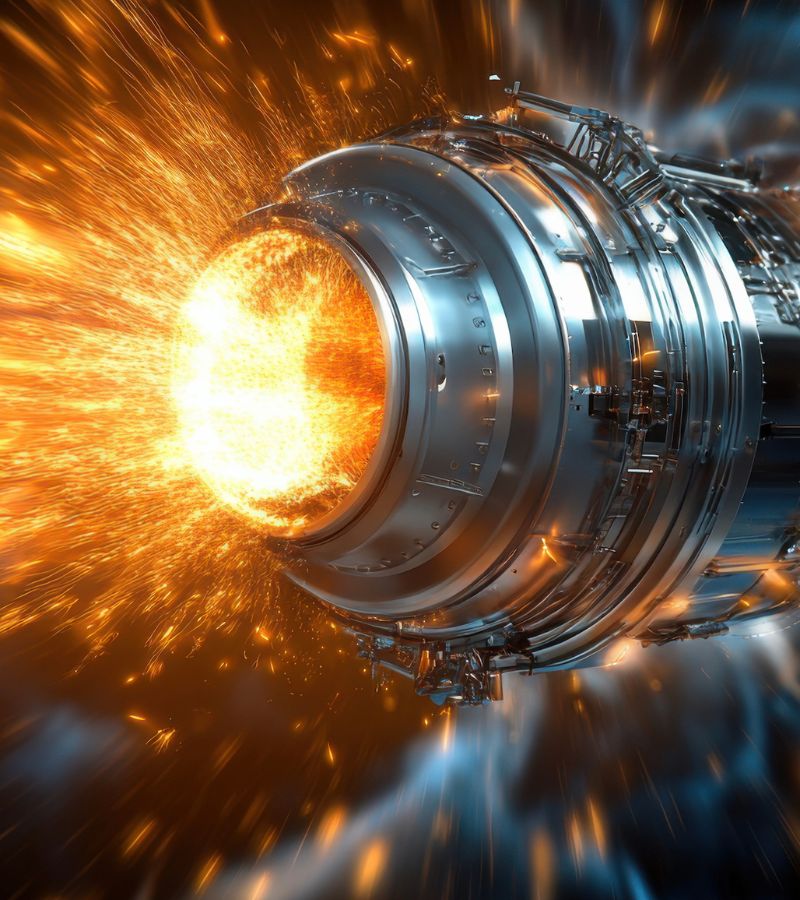

Selon le New York Post, le rapport du Groupe d’experts du Conseil de sécurité de l’ONU sur la Libye fait état d’une opération spéciale en Libye en mars 2020 à l’aide d’un quadricoptère KARGU-2 fabriqué par la Turquie. C’est lors d’un affrontement entre les forces gouvernementales et un groupe dirigé par Khalifa Haftar qui battaient en retraite, à la suite d’un assaut contre la capitale Tripoli, lorsqu’ils ont été «traqués» par des drones sans pilote ainsi que par des «systèmes d’armes autonomes létales».

© STM

UN PREMIER CAS DOCUMENTÉ

Selon le fabricant KARGU-2, est équipé de caméras et transportant de petits engins explosifs. Il fonctionne comme un kamikaze, en explosant lors d’une collision avec une cible. Le Conseil de sécurité de l’ONU a souligné que les données disponibles indiquent que le drone a été programmé pour attaquer et détruire une cible sans commande de confirmation de l’opérateur. Il n’y a aucun détail sur ce qui s’est passé. Le rapport note qu’il s’agit du premier cas documenté de l’histoire où un robot de combat a décidé d’attaquer une personne et de la détruire sans aucune indication directe de l’opérateur humain.

DE LA SCIENCE-FICTION À LA RÉALITÉ

Déjà depuis quelques années des analystes militaires avaient prédit le passage aux armes autonomes. De leur côté une coalition d’organisations pacifistes, de scientifiques, d’universitaires et de politiciens, essaye de faire pression sur l’ONU pour qu’une interdiction internationale soit adoptée, notamment à travers la «Campaign to Stop Killer Robots», «Les systèmes actuels basés sur l’apprentissage automatique ne peuvent pas distinguer efficacement un agriculteur d’un soldat», a prévenu l’analyste Zachary Kallenborn dans The Bulletin of the Atomic Scientists. «Des agriculteurs peuvent tenir un fusil pour défendre leur terre, tandis que des soldats peuvent utiliser un râteau pour renverser une tourelle de canon… Divers facteurs peuvent empêcher le drone de prendre une décision précise», a-t-il conclu.

François Deymier (rédaction btlv.fr)